请教大家,我通过paraview打开一个实例之前保存的state file,但是一加载就闪退。请问这个是什么原因?

sjlouie91

帖子

-

paraview load state闪退 -

集群上并行测试OpenFOAM,并行效率并没有比单节点提升@李东岳

您好李老师,针对这个波动,我之前也发现了,但是我后续又计算过一次,最终320核计算用时577s。总之,就是在240核以上基本上就不太有效果了。

针对您提到的这两个算例,我测试一下。 -

集群上并行测试OpenFOAM,并行效率并没有比单节点提升@number44

感谢你的建议。如果不是CPU的问题的话,有没有可能瓶颈在硬盘读取上?

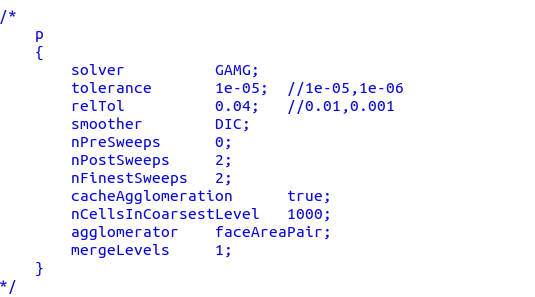

我还有个疑问,我之前在LES算例上测试过GAMG求解器,一般来说GAMG计算更快,但是我不清楚是我设置有问题还是其他别的什么原因,我在使用GAMG的时候计算异常缓慢。

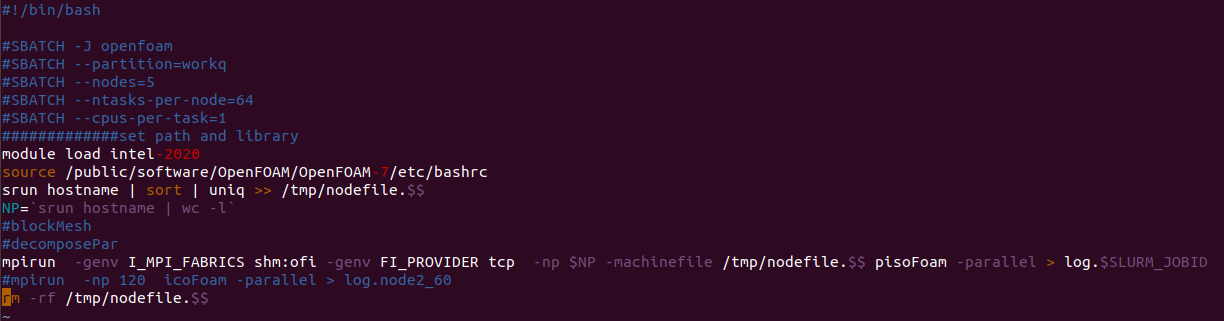

这个是我之前的计算设置,请问是否有针对这个算法的较优的设置参数?

-

集群上并行测试OpenFOAM,并行效率并没有比单节点提升@李东岳

应该走的是infiniband,我还试过更改-genv I_MPI_FABRICS shm:ofi为shm:dapl,但是提示只有shm:ofi和ofi两种。

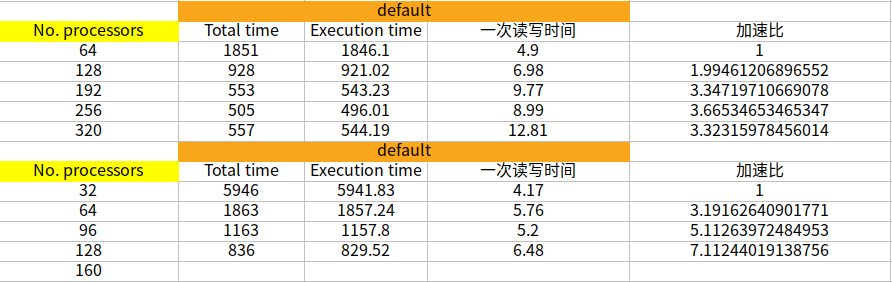

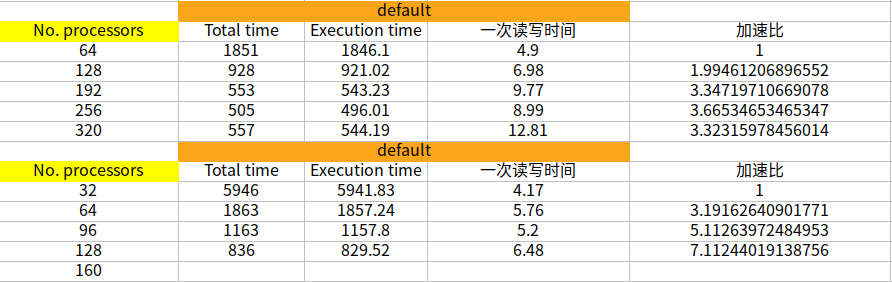

此外,除了一个节点使用32核心,我还测试过1个节点使用48和56核心,我发现不知道有没有可能是计算瓶颈的问题,我只要是用到240核上,每步计算的时长就没法再减小了。1节点64核100步,总共1851s 2节点128核100步,总共928s 3节点196核100步,总共553s 4节点256核100步,总共505s 5节点320核100步,总共557s 1节点32核100步,总共5946s 2节点64核100步,总共1863s 3节点96核100步,总共1163s 4节点128核100步,总共836s 5节点160核100步,总共616s 5节点240核100步,总共526s 5节点280核100步,总共567s请问李老师你们测试采用的算例是什么?

-

集群上并行测试OpenFOAM,并行效率并没有比单节点提升@李东岳 李老师您好,除了刚才发的OpenFOAM的测试性能以外,关于Fluent测试的效果是5个节点的加速比符合线性scale。

-

集群上并行测试OpenFOAM,并行效率并没有比单节点提升@xpqiu 您好,感谢您的回复。

关于-genv FI_PROVIDER tcp,我测试过,必须得加上这个参数,否则没办法计算。至于shm:ofi,我发现好像是否添加这个参数对结果影响不大。 -

集群上并行测试OpenFOAM,并行效率并没有比单节点提升@lzf 还有一个问题想请教一下,你们使用集群计算模块加载的除了intel和intel-mpi,是否还需要其他什么模块吗?

如果可能的话,能否私信告诉我一下你的联系方式方便沟通并行相关问题? -

集群上并行测试OpenFOAM,并行效率并没有比单节点提升@lzf 你好,抱歉回复的晚。请问你指的结果是说最后计算时长吗?还是指的流场结果?

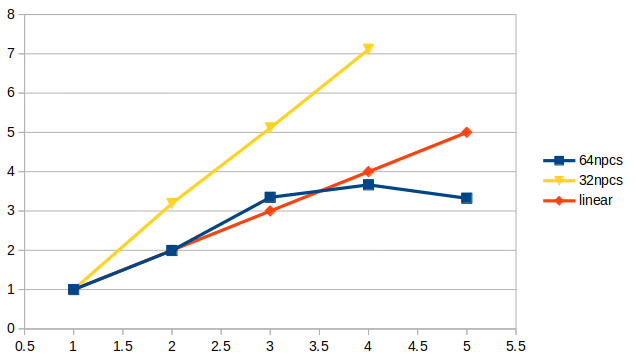

这个是我测试的加速比曲线和计算时长。如果有需要,我可以提供算例cavity文件

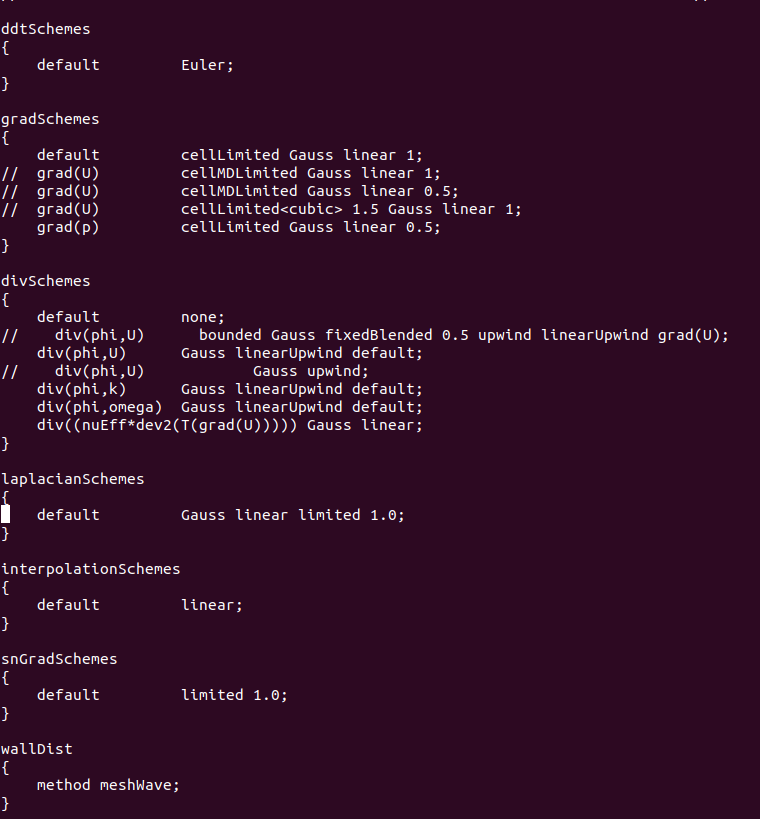

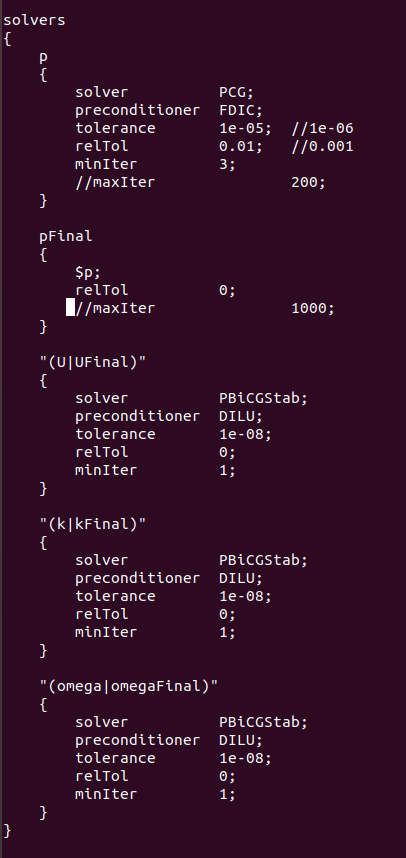

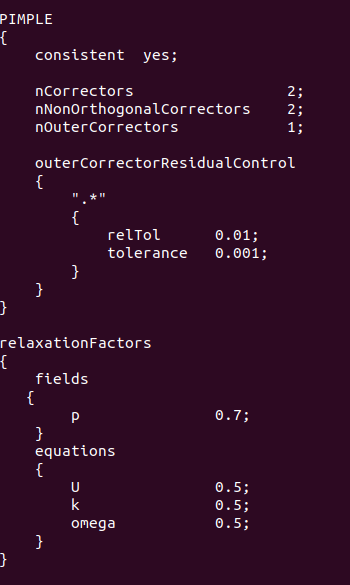

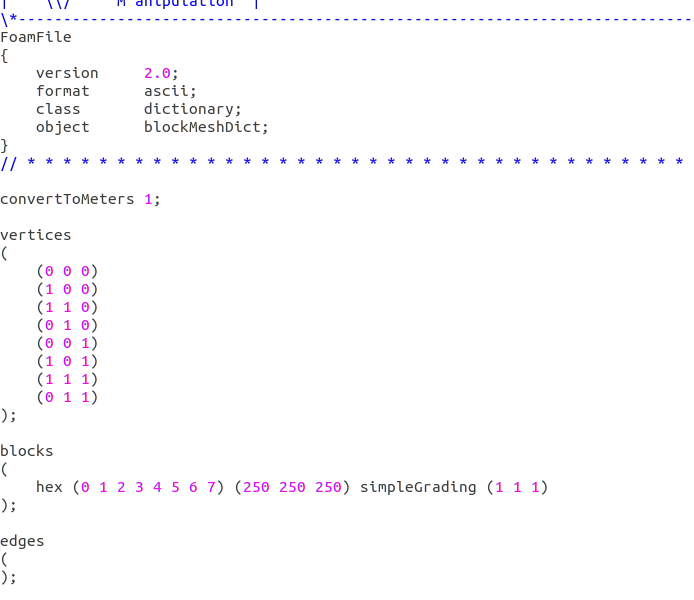

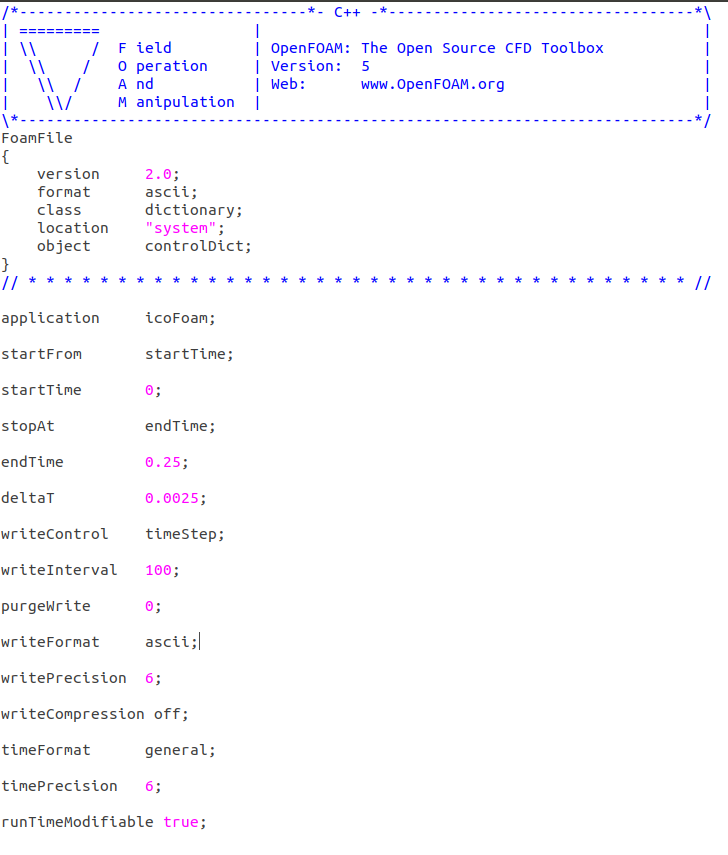

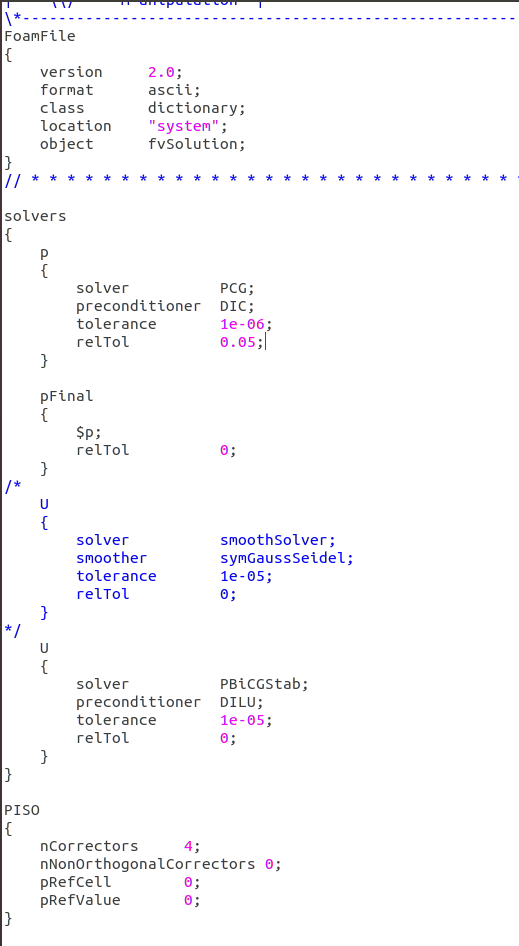

cavity算例的计算设置文件blockMeshDict,controlDict,fvSolution如下,fvSchemes采用tutorials中的设置:

blockMeshDict

controlDict

fvSolution

-

集群上并行测试OpenFOAM,并行效率并没有比单节点提升@李东岳 李老师,您好。我按照您的建议进行了测试,但是每个节点跑满所有核时,在3个节点时还可以实现线性,但是5个节点反而变慢。

请问这种情况还有可能是并行哪里有问题呢? -

集群上并行测试OpenFOAM,并行效率并没有比单节点提升@李东岳

请问这种有问题吗?

-genv FI_PROVIDER mlx -

集群上并行测试OpenFOAM,并行效率并没有比单节点提升@lzf

好的,感谢! -

集群上并行测试OpenFOAM,并行效率并没有比单节点提升@lzf

好的,我试试。请问这个命令是会影响到并行效率吗?抱歉,我不太懂MPI相关命令 -

集群上并行测试OpenFOAM,并行效率并没有比单节点提升@李东岳

好的,谢谢李老师,我先测试一下。 -

集群上并行测试OpenFOAM,并行效率并没有比单节点提升@lzf

你好,请问指的是什么命令?是提交任务的命令吗?

-

集群上并行测试OpenFOAM,并行效率并没有比单节点提升@李东岳

李老师,我是按照单节点64核,双节点128核,以此类推来测试的。目前主要测试的是空腔算例和我自己的LES算例。- 空腔算例:1500万,icoFoam,我是一共运行了100步,平均计算每步运行时间。

一个节点64核心:平均单步19.18s

五个节点320核心:平均单步7.1s

可以看到并行加速比明显未达到预期。我在超算平台上测试过128核心,采用完全相同的计算设置,平均单步6.65s - LES算例,2000万,pisoFoam,同样运行了100个时间步。

这个算例我仅仅测试了256核心和320核心,因为我之前计算的时候采用的就是300核心左右。

我同时测试了每步跑满1000迭代步和最大迭代步设置为100迭代步的情况,以下是具体的数据:

五个节点320核心,最慢平均每步26s,最快平均每步9.2s

四个节点256核心,最慢平均每步29s,最快平均10.5s

作为参考,在超算平台上,同样的算例,336核心,平均每步5s左右。

所以很明显并行测试不达标,主要是因为我们在fluent里测试没有问题,主要问题就在于openFoam,所以目前不知道该怎么解决这个问题。

- 空腔算例:1500万,icoFoam,我是一共运行了100步,平均计算每步运行时间。

-

集群上并行测试OpenFOAM,并行效率并没有比单节点提升@bestucan 在 集群上并行测试OpenFOAM,并行效率并没有比单节点提升 中说:

比表现性能也没有比只核数的呀

比核数,安桌手机超过苹果。

要看处理器型号、主频,硬盘读写速度,有木有阵列,还有BIOS设置什么的。

测算力用 linkpack benckmark 什么的。自己搞得,简单的测不出来,复杂的容易设置错。

感谢您的回复,我们具体的配置是:

infiniband交换机带宽:56Gbps

CPU型号:英特尔至强铂金8375C (每节点双路共64核)主频3.5GHz

硬盘:东芝企业级14T*6,组raid6阵列,系统安装在固态硬盘内

BIOS设置过,但是跑FLUENT速度正常,所以猜测BIOS应该没有大问题有关于测试算例,我采用的1500万网格就是最简单的空腔算例,因为之前我们用过国内的超算平台,我也测试过这个算例。请问,你说的benchmark应该是哪些?是李老师在网站上提到的qDNS吗?还是别的什么?我不是很清楚,请教您一下。

谢谢!

-

集群上并行测试OpenFOAM,并行效率并没有比单节点提升@李东岳

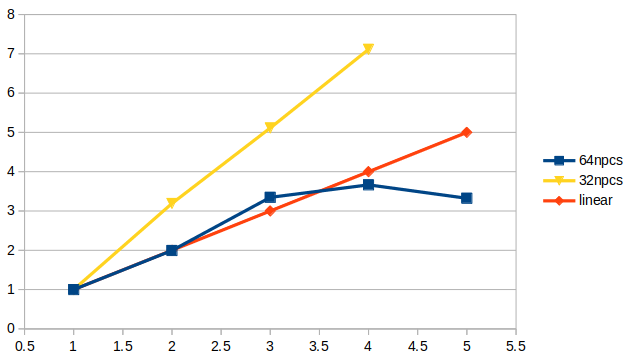

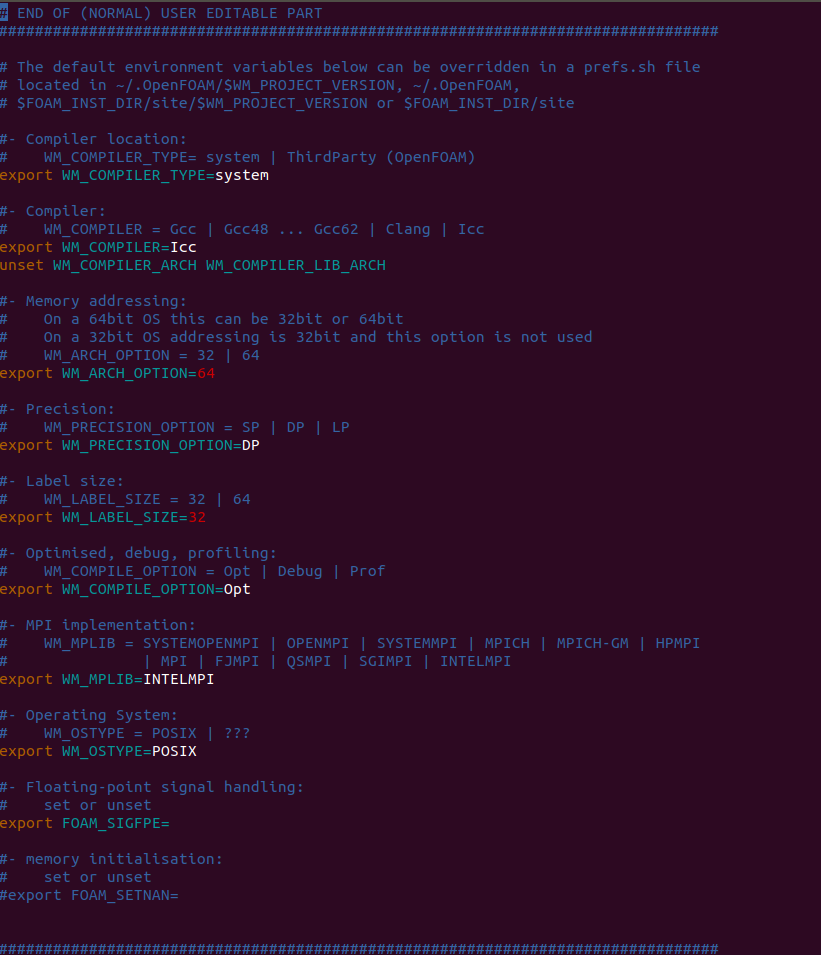

李老师您好,我们的并行计算相关设置都是购买集群的时候帮我们配置的。具体的配置如下:

infiniband交换机带宽:56Gbps

CPU型号:英特尔至强铂金8375C (每节点双路共64核)主频3.5GHz

硬盘:东芝企业级14T*6,组raid6阵列,系统安装在固态硬盘内

总共花了31万多一点Openfoam-7

bashrcfile:

-

集群上并行测试OpenFOAM,并行效率并没有比单节点提升请教大家,我在课题组刚配置的集群上测试OpenFOAM并行效率,一共有320核心,单节点64核心。

我测试1500万网格的算例,单节点运行单步大约19秒,当采用两个节点时,单步11.5秒,并未提升明显。进一步增至3个节点时,计算反而减慢。

第二个LES算例,2000万左右网格,在其他超算平台上测试过采用336核心大约只需要5-6秒,但是在我们自己的集群上我采用4-5个节点,最快都得20秒,明显跨节点通讯有问题。

我采用的编译器是Intel-2018和IntelMPI。因为我们还测试过FLUENT的并行效率,没有出现问题,所以猜测不是硬件的问题,请问有可能是openfoam哪里配置出现问题?

-

pimpleFoam当运行到nOuterCorrectors=3时报错@李东岳 李老师,您好,我按照您的建议进行了相关的测试。结果发现当更换为GAMG时计算比PCG慢非常多,如果我在计算一开始取残差与相对残差值较大时,完全不收敛的情况基本上到500步左右就改善了。但是我又发现一个特别奇怪的现象:

首先通过pimpleFoam (nOuterCorrectors=1) 计算到一定步时计算结果收敛很好,残差基本下降至1e-5左右;但是当我在运行时更改nOuterCorrectors=2时,初始残差立即上升至0.4左右,计算异常缓慢,并且继续运行算例残差也下降不了。请问这个可能是什么原因导致的呢? -

pimpleFoam当运行到nOuterCorrectors=3时报错@李东岳 是压力p的残差每步多要计算1000步。下面是我的计算设置文件,李老师您看是否有什么问题?